Wie man Hadoop auf Ubuntu 18 einrichtet.04 & 16.04 LTS

- 3462

- 986

- Tom Jakobs

Apache Hadoop 3.1 merklich verbessert werden viele Fehlerbehebungen gegenüber dem vorherigen stabilen 3.0 Veröffentlichungen. Diese Version hat viele Verbesserungen in HDFs und MapReduce. Dieses Tutorial hilft Ihnen bei der Installation und Konfiguration von Hadoop 3.1.2 Einzelknoten-Cluster auf Ubuntu 18.04, 16.04 LTS- und Linuxmint -Systeme. Dieser Artikel wurde mit Ubuntu 18 getestet.04 LTS.

Schritt 1 - Voraussetzungen

Java ist die Hauptanforderung für das Ausführen von Hadoop auf jedem System. Stellen Sie daher sicher, dass Java auf Ihrem System mit dem folgenden Befehl installiert ist. Wenn Sie Java nicht auf Ihrem System installiert haben, verwenden Sie eine der folgenden Links, um es zuerst zu installieren.

- Installieren Sie Oracle Java 11 auf Ubuntu 18.04 LTS (Bionic)

- Installieren Sie Oracle Java 11 auf Ubuntu 16.04 LTS (Xenial)

Schritt 2 - Benutzer für Haddop erstellen

Wir empfehlen, ein normales (noch rootes) Konto für Hadoop -Arbeiten zu erstellen. So erstellen Sie ein Konto mit dem folgenden Befehl.

Adduser Hadoop

Nach dem Erstellen des Konto. Um dies zu tun, verwenden Sie die folgenden Befehle aus, um die folgenden Befehle auszuführen.

Su -Hadoop ssh -keygen -t rsa -p "-f ~/.ssh/id_rsa cat ~/.ssh/id_rsa.Pub >> ~//.ssh/autorized_keys chmod 0600 ~/.ssh/autorized_keys

Jetzt SSH zu Localhost mit Hadoop -Benutzer. Dies sollte nicht nach dem Passwort verlangen, aber beim ersten Mal wird das Hinzufügen von RSA zu der Liste der bekannten Hosts aufgefordert.

SSH LOCALHOST -Ausgang

Schritt 3 - Download Hadoop Source Archive

Laden Sie in diesem Schritt Hadoop 3 herunter.1 Quellarchivdatei mit dem folgenden Befehl. Sie können auch einen alternativen Download Mirror auswählen, um die Download -Geschwindigkeit zu erhöhen.

CD ~ WGet http: // www-euu.Apache.org/dist/hadoop/Common/Hadoop-3.1.2/Hadoop-3.1.2.Teer.gz tar xzf hadoop-3.1.2.Teer.GZ MV Hadoop-3.1.2 Hadoop

Schritt 4 - Setup Hadoop Pseudo -verteiltem Modus

4.1. Setup Hadoop -Umgebungsvariablen einrichten

Richten Sie die von der Hadoop verwendeten Umgebungsvariablen ein. Bearbeiten ~/.bashrc Datei und Anhängen der folgenden Werte am Ende der Datei.

Export hadoop_home =/home/hadoop/hadoop export hadoop_install = $ hadoop_home export hadoop_mapred_home = $ hadoop_home export hadoop_common_home = $ hadoop hadoop export hadoop hadoop_hdfs_home Hadoop_Home/sbin: $ hadoop_home/bin

Wenden Sie dann die Änderungen in der aktuellen laufenden Umgebung an

Quelle ~/.bashrc

Jetzt bearbeiten $ Hadoop_home/etc/hadoop/hadoop-env.Sch Datei und festgelegt Java_Home Umgebungsvariable. Ändern Sie den Java -Pfad gemäß der Installation Ihres Systems. Dieser Pfad kann je nach Ihrer Betriebssystemversion und der Installationsquelle variieren. Stellen Sie also sicher, dass Sie den richtigen Pfad verwenden.

vim $ hadoop_home/etc/hadoop/hadoop-env.Sch

UPDATE UPDATE UPTORTE:

Exportieren Sie java_home =/usr/lib/jvm/java-11-oracle

4.2. Setup Hadoop -Konfigurationsdateien einrichten

Hadoop verfügt über viele Konfigurationsdateien, die gemäß den Anforderungen Ihrer Hadoop -Infrastruktur konfiguriert werden müssen. Beginnen wir mit der Konfiguration mit Basic Hadoop Single Knode Cluster -Setup. Navigieren Sie zunächst zu unten

CD $ hadoop_home/etc/hadoop

Kernstelle bearbeiten.xml

fs.Standard.Name HDFS: // localhost: 9000

HDFS-Site bearbeiten.xml

DFS.Replikation 1 DFS.Name.DIR -Datei: /// Home/Hadoop/Hadoopdata/HDFS/NAMENODE DFS.Daten.DIR -Datei: /// home/hadoop/hadoopdata/hdfs/datanode

Mapred-Site bearbeiten.xml

Karte verkleinern.Rahmen.Nennen Sie Garn

Garnstelle bearbeiten.xml

Garn.NodeManager.AUX-Service MapReduce_Shuffle

4.3. Formatnamenode

Formatieren Sie nun den Namenode mit dem folgenden Befehl und stellen Sie sicher, dass das Speicherverzeichnis ist

HDFS NAMENODE -Format

Beispielausgabe:

Warnung:/Home/Hadoop/Hadoop/Protokolle existieren nicht. Erstellen. 2018-05-02 17: 52: 09.678 Info Namenode.Namenode: Startup_msg: /************************************************ ****************************************.0.1.1 startup_msg: args = [-format] startup_msg: Version = 3.1.2… 2018-05-02 17: 52: 13.717 Info Common.Speicher: Speicherverzeichnis/Home/Hadoop/Hadoopdata/HDFS/Namenode wurde erfolgreich formatiert. 2018-05-02 17: 52: 13.806 Info Namenode.FSImageFormatProtobuf: Bilddatei speichern/home/hadoop/hadoopdata/hdfs/namenode/current/fsimage.CKPT_0000000000000000000 mit NO-Komprimierung 2018-05-02 17: 52: 14.161 Info Namenode.FSimageFormatProtobuf: Bilddatei/Home/Hadoop/Hadoopdata/HDFS/NAMENODE/Current/Fsimage.CKPT_00000000000000000 von Größe 391 Bytes in 0 Sekunden gespeichert . 2018-05-02 17: 52: 14.224 Info Namenode.NnstorageretentionManager: Aufbewahrung 1 Bilder mit TXID> = 0 2018-05-02 17: 52: 14.282 Info Namenode.Namenode: Shutdown_MSG: /************************************************************************* ****************************************.0.1.1 ************************************************************ ***********/

Schritt 5 - Start Hadoop Cluster

Beginnen wir Ihren Hadoop -Cluster mit den von Hadoop bereitgestellten Skripten. Navigieren Sie einfach zu Ihrem $ hadoop_home/sbin -Verzeichnis und führen Sie die Skripte nacheinander aus.

CD $ hadoop_home/sbin/

Jetzt ausführen Start-dfs.Sch Skript.

./start-dfs.Sch

Dann ausführen Start marnt.Sch Skript.

./starten Sie das Werk.Sch

Schritt 6 - Zugriff auf Hadoop -Dienste im Browser

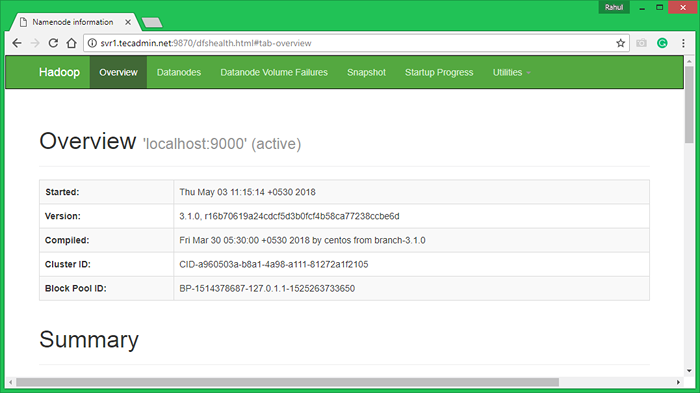

Hadoop Namenode begann mit Standardport 9870. Greifen Sie in Ihrem bevorzugten Webbrowser auf Ihren Server auf Port 9870 zu.

http: // svr1.Tecadmin.Netz: 9870/

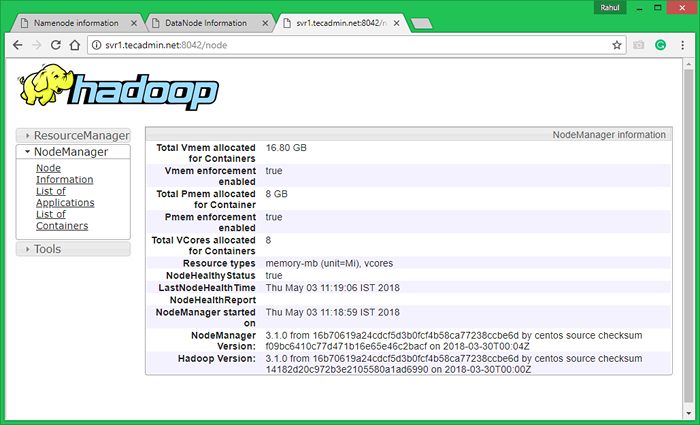

Greifen Sie nun auf Port 8042 zu, um die Informationen über den Cluster und alle Anwendungen zu erhalten

http: // svr1.Tecadmin.Netz: 8042/

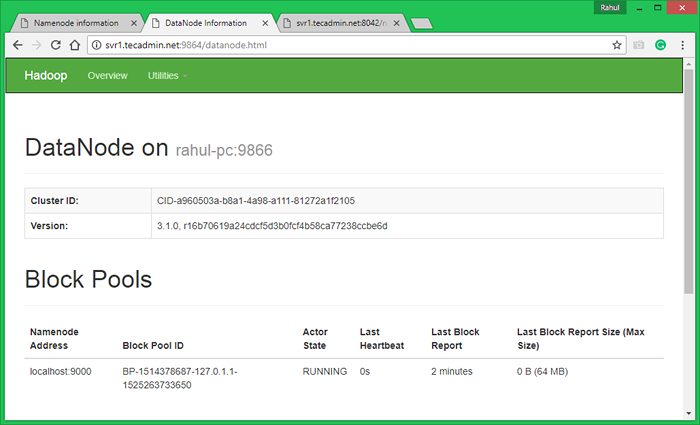

Greifen Sie auf Port 9864 zu, um Details über Ihren Hadoop -Knoten zu erhalten.

http: // svr1.Tecadmin.Netz: 9864/

Schritt 7 - Testen Sie Hadoop -Einzelknoten -Setup

7.1. Machen Sie die HDFS -Verzeichnisse mit den folgenden Befehlen erforderlich.

bin/hdfs dfs -mkdir/user bin/hdfs dfs -mkdir/user/hadoop

7.2. Kopieren Sie alle Dateien aus lokalem Dateisystem/var/log/httpd nach Hadoop -Distributed Dateisystem unter Verwendung des folgenden Befehls

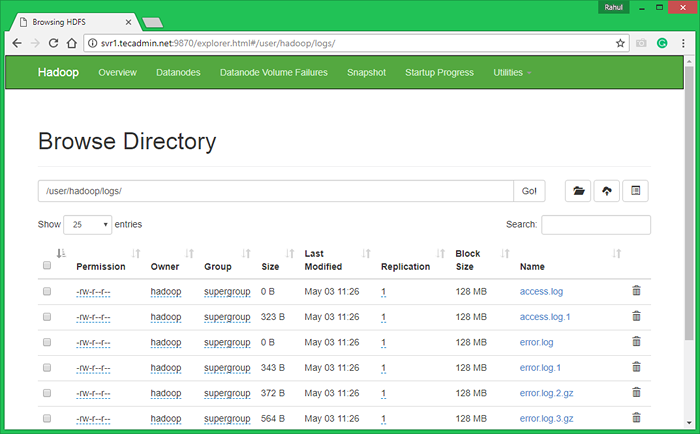

Bin/HDFS DFS -put/var/log/apache2 -Protokolle

7.3. Durchsuchen. Sie sehen einen Apache2 -Ordner in der Liste. Klicken Sie auf den Ordneramen, um sie zu öffnen, und Sie finden dort alle Protokolldateien dort.

http: // svr1.Tecadmin.Netz: 9870/Explorer.html#/user/hadoop/logs/

7.4 - Kopieren Sie nun das Protokoll -Verzeichnis für das Hadoop -Distributed Dateisystem in das lokale Dateisystem.

bin/hdfs dfs -get logs/tmp/logs ls -l/tmp/logs/

Sie können dieses Tutorial auch überprüfen, um WordCount MapReduce -Beispiel mit der Befehlszeile auszuführen.

- « So erfassen Sie die Desktop -Umgebung in Linux -Befehlszeile

- So herunterladen und hochladen Sie Dateien mit SFTP -Befehl »